Análise Envoltória de Dados – Introdução

Mensurar a eficiência operacional de uma indústria não é uma tarefa fácil! É necessário que você conheça quais os valores precisos de inputs e outputs utilizados/produzidos e, claro, o peso que cada um exerce sobre o resultado (preço de mercado).

Para calcular a eficiência final, portanto, você terá de dividir a soma ponderada dos outputs pela soma ponderada dos inputs e comparar o resultado com um valor padrão. Este padrão, geralmente, é um valor pré-calculado do quanto poderia ter sido produzido com aquela quantidade de recursos em condições ótimas de funcionamento, estabelecendo desta forma, uma relação funcional entre a quantidade de recursos e produtos. Estes modelos são conhecidos como modelos paramétricos.

Todavia, como calcular a eficiência operacional de sistemas onde seja impossível estabelecer o preço de mercado dos inputs e outputs? Daí reside toda a dificuldade…

O primeiro a se deparar (ou a resolver) este problema foi o então doutorando americano Edward Rhodes, que pesquisava a eficiência de um programa de acompanhamento de crianças carentes implantado em algumas escolas. A ideia era comparar a eficiência educacional destas escolas com as que não haviam aderido ao programa. Todavia, Rhodes não queria arbitrar pesos às variáveis, o que poderia gerar vieses e inexatidão nos resultados.

Rhodes, ao estudar sobre mensuração de eficiência, deparou-se com o artigo de Farrel (1957), que estabelecia os pressupostos básicos para o cálculo de eficiência.

Baseados neste artigo, Abraham Charnes (1917-1992) e Willian Cooper (1914 a 2012), orientadores de Rhodes, propuseram uma metodologia que calculava a eficiência das unidades, no caso escolas, ou genericamente DMU (decison making units) de forma comparativa, onde o peso que cada variável exercia sobre o resultado era calculado por programação linear.

Desta forma, os pesos eram calculados de forma a maximizar a eficiência de cada DMU. Uma DMU que houvesse sido ineficiente nesta configuração, seria ainda mais ineficiente em qualquer outra.

A unidade mais produtiva era colocada como benchmark para as demais, sendo lhe atribuída a eficiência máxima (100% ou 1). Às demais unidades era atribuída a eficiência relativa ao percentual da produtividade atingida quando comparada com a DMU benchmark.

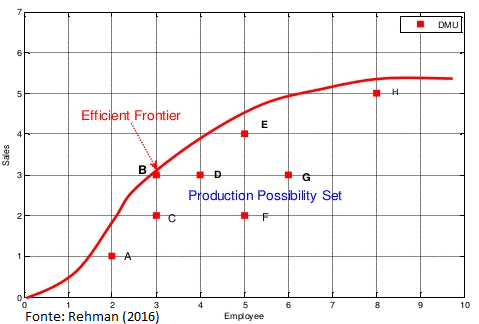

Este modelo considerava retornos constantes de escala, onde a eficiência era demonstrada graficamente por uma reta partindo da origem, conforme mostra o gráfico abaixo.

Fonte: Open Source DEA

Neste exemplo, apenas a DMU E é eficiente, as demais são ineficientes.

Neste modelo, conhecido como CCR em homenagem aos seus criadores (Charnes, Cooper e Rhodes), uma redução nos inputs de uma unidade considerada eficiente, exige uma redução proporcional nos outputs para que continue eficiente e virse e versa. Esta característica é conhecida como axioma da proporcionalidade.

O modelo CCR é conhecido também como CRS (Constant Return to Scale).

Mas, como na prática a maioria dos sistemas organizacionais possuem retornos variáveis de escala, não demorou muito Charnes e Cooper com o auxílio de Banker, criaram o modelo BCC, que considerava retornos variáveis de escala. O modelo recebeu este nome em homenagem a seus criadores, sendo conhecido também como modelo VRS (Variable Return to Scale). Neste modelo, o axioma da proporcionalidade foi substituído pelo axioma da convexidade, como será melhor definido nos próximos posts sobre o assunto.

Esta técnica, por desconsiderar o impacto que a escala exerce na eficiência, é capaz de computar como eficiente DMUs de diferentes portes, conforme demonstra o gráfico abaixo.

Fonte: Open Source DEA

Após a técnica BCC, diversos outros métodos DEA foram criados e serão tratados nos próximos posts.

Não deixe de acompanhar os próximos artigos!

Cite este trabalho:

BARBOSA, F.C. Análise Envoltória de Dados – Introdução. Disponível em: <https://conhecimentolivre.org/analise-envoltoria-de-dados/>. Acesso em: xx de xxxx de 20xx.

You ought to be a part of a contest for one of the greatest sites online. I am going to recommend this website!

Itís hard to come by knowledgeable people on this subject, however, you seem like you know what youíre talking about! Thanks

I needed to thank you for this fantastic read!! I absolutely enjoyed every bit of it. I have you saved as a favorite to check out new stuff you postÖ

Im extremely pleased to uncover this site. I need to to thank you for your time for this particularly fantastic read!! I definitely enjoyed every little bit of it and I have you saved as a favorite to look at new information on your web site.

מקומות רבים מציעים חדרים דיסקרטיים בתשלום

לפי שעה כאשר שם תוכלו לבלות יחד למספר שעות בלי הפרעות,

בלי טלפונים רק אתם ובן או בת זוגכם ולשלב חוויה

אינטימית וחושית שלכם בלבד או ביחד עם

מסאג’ מפנק במיוחד על פי מה שתבקשו.

אין ספק שכל גבר זקוק למעט חברה בחייו ועבור אנשים בררנים במיוחד, בעלי סטנדרטים גבוהים, השירות מהווה פלטפורמה מעולה לבחור על פי קריטריונים שונים מפגשים אצלי בנתניה.

אין חברה טובה יותר מאשר נערות ליווי בראשון לציון – לוהט

וחושני. במידה ומדובר באפליקציה מתקדמת

ורחבה, תוכלו למצוא בין היתר גם מידע

פרטני על נערות ליווי ערביות בראשון לציון.

בין אם אתה מגוש דן או לא, כדאי לבדוק בראשון לציון.

לא כל סוכנויות הליווי בראשון לציון זהות.

ה”להיט” של הפנטזיות של גברים במשחקים אינטימיים הוא אחיות ש”מרפאות”

אותם באמצעות טיפולים מיוחדים של דירות דיסקרטיות בראשון לציון.

ראשון לציון הוא סוג של “פרבר” של גוש דן’ בדומה לאזורים אחרים בגוש דן, ראשון לציון היא ביתם של מגוון רחב של מסעדות, בתי קפה, חנויות וברים שכולם ידועים בשירות יוצא דופן שהופך את הפרבר הזה למקום נהדר

לבקר בו.

מטרת סיווג זה היא לאפשר לגולש להגיע אל נותן השירות או בית העסק הקרוב ביותר אליו ברגע נתון זה.

תושבי הערים נערות ליווי באילת השכנות של

ירושלים יכולים גם הם להזמין נערות ליווי פרטיות בכל רגע נתון.

המחיר של נערות ליווי בירושלים הוא שווה לכל כיס,

ככה שגם אתה יכול להרשות לעצמך בילוי מפנק עם נערת ליווי.

מנגד, כל עוד תקבלו עיסוי ברמת-גן בלבד לאורך כ-45 דקות ועד

שעה, המחיר שתצטרכו לשלם יהיה נוח הרבה יותר

ויהפוך את חווית העיסוי לנגישה

גם לכם! מנגד, כל עוד תקבלו עיסוי בגבעתיים בלבד לאורך כ-45 דקות

ועד שעה, המחיר שתצטרכו לשלם

יהיה נוח הרבה יותר ויהפוך את חווית העיסוי לנגישה גם לכם!

מנגד, כל עוד תקבלו עיסוי בקרית אתא בלבד לאורך כ-45

דקות ועד שעה, המחיר שתצטרכו לשלם יהיה נוח

הרבה יותר ויהפוך את חווית העיסוי לנגישה גם לכם!

דירות דיסקרטיות באשקלון הן המקום היחידי בו תוכלו להגיע ולבלות בילוי אינטימי עם כל בת זוג או

פרטנר מזדמן. עם כל נשימה שאתם לוקחים דמיינו שאתם

מכניסים אל גופכם אור נקי, ועם

כל שאיפה אתם פולטים את שאריות היום.

בשירותים אלו. בסופו של דבר לכולם מגיע ליהנות.

בסופו של דבר אתם רוצים

מיטה נקייה ונוחה בה תתפנקו ממגע ידי הזהב

של הנערות המעסות. הבילוי. הנערות זורמות אתכם לכל

מקום ולכל דבר שתרצו לעשות. כל נערות הליווי בראשון לציון זורמות וקשובות לצרכים ולרצונות שלכם.

מצב רוח רע, מחסור ברגשות חיוביים, עייפות כללית ומצב בו אתה “מוותר” –

כל זה נמס כמו עשן מתחת לידיים המיומנות של

המטפל. גם אם אינכם סובלים מכאבים, אך חשוב

לכם להרחיב את טווחי התנועה של

המפרקים בגופכם, או אם לחילופין אתם מעונינים לשפר את זרימת הדם לידיים והרגליים שלכם (רלוונטי ביותר עבור נשים הרות), או להפחית

את רמות הסטרס בגופכם ובנפשכם, אתם עשויים לצאת נשכרים מטיפול בעיסוי קליני.

נערות ליווי באות לספק את הצורך הבסיסי של בחורים כל מטרתן היא לגרום

לך להרגיש רצוי, יפה ומיוחד.

אחת מהתכונות של נערת ליווי בראשון לציון היא לגרום לגבר שלו היא מעניקה ליווי יוקרתי,

אינטימי ואישי הוא להרגיש גברי,

נחשק ומאושר. הן תתייחסנה לגבר שלהן בכבוד ותזרומנה אתו להגשמת פנטזיות ועונג אמתי תוך כבוד

הדדי. כל התמונות של הגברות שלנו אמיתיות ועולות בקנה אחד עם המראה שלהן.

כל עוד תקבלו עיסוי בירושלים באופן חד פעמי, תהיו מוכנים להשקיע

כל סכום.

כאשר תחום הרפואה המשלימה פורח, אך טבעי שיצוצו עוד ועוד קליניקות להשכרה.

מאז סוף שנות ה-90 פועלות קליניקות משפטיות בכל בתי-הספר למשפטים בישראל.

מרפאת שיניים איי סמייל הינה מרפאה ייחודית בתחום טיפולי שיניים לילדים.

מסלולים הינה חברת הסעות וטיולים במרכז, המספקת שירותים ללקוחות פרטיים ועסקיים בכל רחבי

הארץ. פרחי מזי בנתניה הינה חנות פרחים המתמחה

בסידורי פרחים מעוצבים בשילוב אלמנטים עיצוביים

מיוחדים ומקוריים. איתכם ביצירת

רגעים מיוחדים באירועים שלכם כל אירוע, הוא רגע

שיא עבור המארגנים שלו. לכל אחת יש מראה וסגנון מיוחד משלה וכל אחד מהגברים יכול למצוא את זו שמתאימה בול לטעם

שלו והעדפותיו המיניות. לכל אחד יש את הסיבות שלו.

כאשר זה נוגע לנערות ליווי, לכל אחד יש את הסיבות בגינן הוא מזמין את

השירות, הסיבה שלי הייתה הגשמת פנטזיה.

אבל זוהי אינה הסיבה היחידה מדוע תעדיפו דירות דיסקרטיות

בקריות על פני בתי המלון.

מעסים שמעניקים עיסוי בקריות ימליצו לכם להתנתק מהמכשיר כחצי שעה לפני העיסוי.

בכל מקרה, הזמנתי אותה לחדר לפי שעה

וכשהיא הגיעה דווקא שמחתי לגלות שהיא יותר יפה ממה שחשבתי.

זה הזמן ליצור איתנו קשר ואנחנו נשמח

לעמוד לרשותכם בכל שעה!

מכיוון שאנחנו חיים בעידן האינטרנט, בו כל המידע זמין ונגיש בלחיצת כפתור פשוטה, אין צורך להשקיע מאמצים בכדי למצוא נערות ליווי בבת ים

או בכדי לבצע את הבחירה המתאימה מתוך ההיצע.

בניגוד לתרופות בתחום הפסיכיאטריה, ביחס לגישות פסיכותרפיות אין בנמצא תהליך אישור פורמלי מוסכם, ובכל זאת – רבות מהן מגובות בראיות שמסתמכות על

מחקרים מרובי משתתפים ותומכות ביעילות הטיפול להפחתת סימפטומים של הפרעות

ספציפיות, ביניהן דיכאון וחרדה.

הטיפול מתבצע על ידי קרצוף, פילינג ועיסוי בסבון

ארומטי ריחני. אומר יוסי ומוסיף כי במהלך הטיפול לא מעט אנשים נפתחים וחולקים איתו דברים אישיים,

“כייף לי להיות האדם שלא רק מטפל בהם בגוף אלא גם בנפש, מקשיב להם ואם יש אפשרות לעזור, אני תמיד שמח לעשות זאת. כמובן שכל מה שהם חולקים איתי נשאר בחדר הזה, בדיסקרטיות מלאה, בדיוק כמו במרחב שבין פסיכולוג למטופל שלו”.

אתה תשכח מכל הבעיות שלך ותשיג איתי אקסטזה… כאשר מזמינים מעסה הוא כבר ידאג להביא עמו את

כל האביזרים שנחוצים לו כמו מיטת

טיפולים, שמן עיסוי ואף נרות.

אף מומלץ להתכונן לעיסוי על ידי

ביצוע של תרגילי נשימה ומתיחה באזורי הגב והצוואר, בכדי להתניע

את הזרימה הלימפתית כבר לפני העיסוי, ועל

ידי כך לעודד אותה להתנקז מהר יותר מהגוף.

כמו כן, אם אתם מחפשים עיסוי ארוטי בפתח תקווה באזור, סביר מאד להניח שאתם גם תוהים מה היתרונות של הטיפול הזה בכלל,

ומתברר שגם זה משהו שאנשים לא כל כך מבינים לעומק ולכן נחלוק אתכם גם את המידע החשוב הזה.

באופן טבעי, עיסוי ארוטי, על אף היותם טיפולים מקצועיים שבהחלט

מביאים להקלה על הגוף והנפש,

הם כאלו שאנשים לא נוטים להתייעץ לגביהם עם חברים או בני משפחה וזה משהו

שיכול להפוך את האיתור של עיסוי ארוטי בפתח תקווה למעט מורכב יותר.

לצורך כך ניתן להיכנס לפורומים מקצועיים

ברחבי הרשת ולשאול שם אנשים אובייקטיביים לגבי עיסוי ארוטי

בפתח תקווה באזור. הצג מספר |. יפתח בשעה: 9:00.

בקליניקה של קורל תמצאו מגוון רחב של טיפולים מקצועיים : עיסויים מכל

הסוגים, כגון עיסוי שוודי, עיסוי קלאסי, אבנים חמות, עיסוי

ספורטאים, בנוסף גם פילינג גוף, מניקור ופדיקור… ללא פשרות זה קורה על הצד הטוב ביותר, מגוון

שירותים שנמצאים בתוך דירה שנבדקה

מראש בצורה פרטית והדיסקרטית ביותר באזור פתח

תקווה. כאן תוכל למצוא מגוון רחב

של דירות סקס בכפר סבא והסביבה כולל כתובות, טלפונים וניווט

שיביא אתכם היישר לעונג. כאן תוכלו

למצוא את הטוב ביותר בדירה דיסקרטית שאף אחד לא יגיע או יחפש אתכם- דירות פרטיות נקיות העונות

על כל הסטנדרטים החשובים והקריטיים

והכול במטרה אחת – לעשות לכם את ההנאות כמה שיותר גבוהות , חזקות ומעצימות.

מקובל לעשות זאת בתהליך הרחבה איטית

המונעת טראומה לצוואר הרחם שעלולה להיגרם בעקבות

הרחבה מכשירנית מהירה. ישנם אנשים שמקבלים עיסויים למטרות

פינוק וכייף בביתם ולפעמים מגיעים לדירה דיסקרטית בראשון לציון אך גם ישנם אנשים המבקשים

לעבור עיסוי במרכז בעקבות כאב מסוים.

ריפיון הגוף מגיע לאחר העיסוי בראש העין,

אך לאורך העיסוי המטופל לעיתים ירגיש חוסר נוחות ומעט כאב בשל הלחיצות.

תוכלו להזמין מתוך מגוון של עיסויים את העיסוי שלו אתם זקוקים כמו: עיסוי מרגיע ונעים,

עיסוי משחרר, עיסוי בשמן חם, עיסוי טנטרי,

עיסוי מקצועי ומפנק בחדרה .

איך בוחרים מעסה מקצועי מתוך המגוון באתר?

שימו לב שהתמונות והטלפונים שתראו באתר הן של בחורות העובדות באיזור צפון הארץ

בלבד. מחפשים באתר בחורה בדירה

דיסקרטית בקריות והנה לך ערב סקסי שקט

וחופשי מדאגות. תוספות כאלה ואחרות שתרצו בדירה מעבר לפירוט הרשום

במודעה. אם אתם גולשים באפליקציה שלנו, לחיצה על מספר הטלפון במודעה ואתם כבר מקושרים.

דמיינו לעצמכם דירה דיסקרטית בכרמיאל מעוצבת ומושקעת, עם מספר בחורות חטובות ויפות,שכל מה שהן רוצות זה רק לספק

אתכם.אבל למה לדמיין, שאפשר להגשים.

מעוניינים למצוא דירה דיסקרטית בכרמיאל?

אצלנו כמובן, תוכל למצוא מגוון רחב של בחורות

חטובות, יפות וסקסיות, שהינן מקצועיות

ומעניקות את מיטב השירותים

לפי בחירתך. כאן תוכל למצוא מגוון

רחב של דירות סקס. דרך טובה להיפגש

מבלי שמישהו ידע על יחסים אלו היא להיפגש בתוך

דירות דיסקרטיות אשר מאפשרות לשמור על סודיותכם.

לכן דירות דיסקרטיות בירושלים מאפשרות לכם לצאת למיני חופשה קצרה.

אך הפינוקים אינם נגמרים בזאת, אם תרצו לערוך

ערב רומנטי לבת הזוג או המאהבת, ישנן דירות בהן ניתן להזמין

הפתעות נוספות אשר יחכו לכם בחדר,

כמו בלונים, שוקולדים, שמפנייה ודברים בסגנון.

זה הסיבה שבאתרינו תוכלו להסיג לא מעט נערות

ליווי אשר אנכנו החלתנו לחשוף את הפנים שלהן,

ולפי כך תוכלו לצפות בדיוק את מי אתם הולכים להזמינים ללא הפתעות לא נעימות.

רוב סוכנויות הנחשבות בארץ עובדות איתנו ולמעשה תוכלו למצוא מגוון רחב של

נערות ליווי. נערות ליווי ברמת השרון נתפסות כאינטליגנטיות

ואלגנטיות מאד ולכן הם מתאימות מאד לפגישות עסקים או

מסיבות מפוארות של החברה איפה שיהיה

נוכח הבוס וכל השותפים העסקיים.

בכל אופן, בין אם אתם בוחרים בדיל סוויטות ברמת

הגולן ברגע האחרון עם ארוחת בוקר, או

צימרים ברמת הגולן דקה 90 ללא ארוחה, כדאי לדעת שאפשר אפילו

להזמין למתחם הצימרים סדנאות שונות

להכנת אוכל (שוקולד, גבינות, חמאה ופיצות).

ברגע כזה אני מרגיש כמו יקובוביץ ‘, בתוכנית “שדה הנסים”, תמיד נותנים לו מתנות.

רוב הערים במדינתנו נבנו מכוח האינרציה ולפיכך הן תמיד חסרות בתשתיות ונראות

כטלאים על גבי טלאים. לא חסרות נערות ליווי בעפולה, יש שפע ואפשר למצוא

הכל. דירות דיסקרטיות בעפולה, הן בהחלט יכולות לקחת אתכם למקומות שלא הכרתם בעבר.

מתלבט אילו דירות דיסקרטיות בעפולה

יספקו לך את השירות הטוב ביותר?

בעבר היה נהוג לפנות אל בתי המלון אבל כיום ,כשיש פורטל מאומת עם מידע אמין ועם פינוקים רבי עוצמה כל מה שצריך זה לבחור דירות דיסקרטיות בעפולה

ולצאת למסע מענג ביותר. כמו כן, תוכלו להזמין קבוצה של

אנשים לחוויה איכותית ומרגשת עליה ידברו כולם כל השנה!

האפשרויות הן בלתי מוגבלות; ניתן לבלות בדירות

דיסקרטיות עם בן או בת הזוג; לבלות עם המאהב או המאהבת;

להזמין בחורה שזה עתה הכרת באיזה בר או מסיבה

או לבלות עם נערות ליווי. עיסוי מפנק בכפר סבא/רעננה, ניתן להזמין עד הבית בכפר סבא/רעננה

כמתנה לך, לבן הזוג לחברה או לאיש עסקים

שאתם מעוניינים לפנק. עיסוי עד הבית בתל אביב שאנו מעניקים מאפשר לכם ליהנות מכל העולמות: מצד אחד, אתם

זוכים לקבל מסאג מפנק ואיכותי מהצוות

המקצועי של אמרלד ספא, עם כל הציוד,

האבזרים והאווירה הנלוות

לטיפול.

בכל מודעה תמצאו קישור למקום הכוונה דרך ווייז וחיוג ישיר בלחיצה

על מספר הטלפון. לגבי עלויות, אירוח באותם חדרים לפי שעה

באזור המרכז תלוי ברמת האירוח ובמספר השעות,

לא יחייבו אתכם עבור לילה אלא רק

לפי מספר השעות כשהמחיר נע בין 80 ₪ לשעה ועד 300 ₪ לשלוש שעות בסוויטה מפוארת!

חדרי האירוח משמשים לרוב זוגות צעירים לצורכי בילוי רומנטי על מנת לצקת רומנטיקה לחיי הזוגיות, שם הם

מוצאים את האפשרות לבלות יחד מבלי שאף אחד יפריע,

על הדרך הם גם נהנים מהפינוק שיש

בצימר ומנזמן איכות שאין שני לו.

השירות הדיסקרטי הניתן בחדרי האירוח במרכז בא לידי ביטוי במספר דרכים, אחד מהם הוא הכניסה לחדר שנעשית באופן עצמאי, תינתן לכם

האפשרות להגיע למתחם ולא להיפגש עם בעלי המקום, ברוב חדרי האירוח הדיסקרטיים, תמתין לכם תיבת שירות בה יחכה לכם

מפתח לחדר ואת התשלום תשאירו בתיבה וכך תוכלו לשמור על פרטיות מוחלטת.

רגע של פסק זמן, בילוי זוגי , פגישת עסקים ולכל מטרה

שמקדשת את הרגעים האלו, האפשרות

לבלות בצימר זמין בכל שעה, קרוב למקום מגוריכם

או לכל מקום בו תימצאו, במחירים שווים לכל כיס.

אם אתם מחפשים ספא זוגי מפנק במיוחד ליום האהבה,

יום הולדת ו/או לכל אירוע כזה או אחר,

הגעתם למקום הנכון ביותר! אם בחרתם

חדר לפי שעה עם ג’קוזי אז לרוב הוא יהיה ליד המיטה, ג’קוזי זוגי עגול או מרובע, מבעבע בחמימות ולאחר תוכלו

להתנגב בחלוקי מגבת רכים, והכי חשוב כל זה בפרטיות מלאה, תוכלו להסתובב בחלל הצימר כביום היוולדכם,

ולהגשים פנטזיות שלא חשבתם עליהם בכלל

בבית הפרטי שלכם.

אתה יכול להזמין נערות ליווי בכפר סבא ולעשות הערב

משהו יוצא דופן. זהו אחד מהעיסויים בכפר סבא הפופולאריים ביותר אשר לקוחות שאוהבים

להתפנק מזמינים. הרגישות

באה לידי ביטוי ברגישות לתנאי מזג אוויר ורגישות ללחצים שונים אשר עלול לגרום

להרגשת כאב. ישנם אנשים שמקבלים עיסויים

למטרות פינוק וכייף בביתם ולפעמים מגיעים

לדירה דיסקרטית בלוד אך גם ישנם אנשים המבקשים לעבור עיסוי במרכז בעקבות כאב מסוים.

אנשים רבים מכל רחבי הארץ מגיעים לעיר בשביל עסקים,

יבוא ויצוא. נערת ליווי ערביה בתמונות אמיתיות חדשה בליווי במרכז הארץ.

תושבי ראשון לציון והסביבה משתמשים בכדי לבחור מקומות

לבילוי מיוחד בעיר, אבל האמת היא שהשירות מיועד ללקוחות מכל רחבי הארץ.

מהעירייה נמסר, כי יתר ההיצע מיועד לשוק החופשי.

אנו דואגים כי התמונות יגיעו מהבחורות הסקסיות בעצמן ובניגוד לאתרים

אחרים, לא ניתן למצוא תמונות באיכות נמוכה או תמונות משוכפלות.

מובטח לכם כי תמצאו נערת ליווי להזמין בכל שעה ביום ובכל איזור בישראל, למעט איזורים שלצערנו לא קיימים בהם שירותי ליווי דוגמת באר שבע

או ירושלים. לרוב ישנם אנשים שמרשים לעצמם להזמין עיסוי מפנק רק

באירועים מיוחדים אבל לא אצל כולם מדובר על עיסוי מפנק למטרת עונג בלבד, כי אם גם למטרת ריפוי.

השכרת חדרים וצימרים לפי שעה פונה

לכל קהל היעד בו האהבה מתגוררת: זוגות גרושים

שאינם מעוניינים עדיין להזמין את בן

או בת הזוג לביתם, זוגות דתיים ביום המקווה שאין להם

מקום שקט ורומנטי, חיילים שמחפשים

אירוח רומנטי במחיר שפוי, זוגות צעירים שמחפשים להתפנק קרוב לבית למספר שעות ולא לשלם לבייביסיטר

הון, זוגות חד מיניים וכל זוג

החפץ ברגעי אושר ונחת.

מאיר עבדו – הובלות ומנופים – מתמחים במתן שירותי משאיות מנוף

והובלות בפריסה ארצית. משיאות מנוף סל עד

60 מטר, משאיות מנוף זרוע עד 200טון. אנו

מספקים את שירותי המהנפה וההובלה כולל הובלת מטענים חורגים ומטענים כבדים במיוחד.

מאסטר פלאמר מספקים שירותי אינסטלציה מקיפים עם למעלה מ-25 שנות

ניסיון. אתר המשחקים הגדול בישראל

עם אלפי משחקים בחינם ! ספר טלפונים חינם למספרי חיוג

מקוצר – כוכבית בישראל. חברת א.ג גידור הינה חברה שהוקמה לאחר שנים

רבות של ניסיון והתמחות בביצוע התקנת והרכבת כל

סוגי הגדרות החברה מבצעת עבודות גידור בכל רחבי

הארץ תוך הקפדה על איכות גבוהה, מקצוענות ללא פשרה,

זמינות ומתן שירות אמין ולשביעות רצון הלקוח.

אנחנו מתמחים בהקמת מערכות סולאריות לייצור חשמל למגזר הפרטי והעסקי ומספקים שירות EPC כלומר אנו מספקים פתרון מלא משלב התכנון ועד ההפעלה

הסופית. מכון הנותן שירות אבחונים דידקטיים, אבחונים פסיכודידקטיים, אבחוני moxo, אבחוני לקויות

למידה, אבחונים רגשיים. וי קלאס חברת נסיעות במיניבוסים, הסעות ו מוניות גדולות.

חברת דמיטרי הדברות בעלת צוות

מקצועי ומנוסה בתחום ההדברה מציעה שירותי הדברה שונים עם

חומרי הדברה ידידותיים לסביבה

שלא מסכנים אף אדם והסביבה. קיבלתי עיסוי רפואי מקצועי ביותר,

מושקע, מדויק, עם הסבר ורגישות.

יש אנשים שמחפשים עיסוי אירוטי במרכז או עיסוי אירוטי בקריות כי זוהי תקופה שבה אין להם

אהבה.

תחומי האחריות שלה כוללים יצירת אשליה של אשתו של אדם מכובד ועשיר.

לשיטתם, העובר אינו אדם עד שיוולד, ובמיוחד כל עוד אין

לו יכולת קיום מחוץ לרחם. הנטייה לחשוב כי כל אחד שמעביר את ידיו על גופו

של אדם אחר נקרא מעסה, שגויה. נערות ליווי דרום – כשהכול מתנקז לנקודה אחת זה יכול להיות פשוט ובעיקר להיות בדיוק מה שאתם צריכים ורוצים,

תארו לעצמכם מקום שבו כל הטוב מתנקז לנקודה

אחת, גם באזור שלכם, גם כל השירותים יחד והכי חשוב?

גם אם תזמינו עיסוי מפנק בלוד לבית המלון שבו אתם שוהים בבירה,

האווירה תשתנה, האורות יתעממו ונרות ריחניים יהיו בכמה

פינות החדר, אתם תשכבו רק עם מגבת

על גופכם שתרד אט, אט, ככל שהעיסוי יעבור לחלקים השונים בגוף.

ראשית, על מנת למצוא עיסוי מפנק

בלוד באזור שבו אתם גרים,

מתחיל בטלפון כאשר אתם מיידעים את המעסה ומקבלים מידע אתם מרגישים בטוחים

יותר להתחיל את העיסוי. במקום הטוב ביותר נלקחו כל הפרמטרים החשובים ביותר ועכשיו

כל מה שנשאר זה רק לבחור את מי שמתאימה לכם לבילוי שאולי לא

יחזור על עצמו. לא כל אחת יכולה ולא כל אחת בנויה לזה- בטח לא הנשים שלכם, נכון?

אחד הנשים הסקסיות שיש לאיזור הדרום להציע.… מרבית המארחות שתפגשו בעיר הן תושבות

המקום, להבדיל ממקומות אחרים בהם

הנשים העובדות במקום מתגוררות בעיר אחרת מפני

שמרבית הנשים המחכות לכם בתוך דירות דיסקרטיות בבאר שבע הן

תושבות העיר, הן ישתדלו במיוחד להעניק

לכם פגישה בלתי נשכחת שתעורר בכם רצון לחזור ועוד ועוד.

חדרי אירוח לזוגות הם חדרים שנבנו ותוכננו מראש להוות מקום מפגש

אינטימי ולכן הם מושקעים ומאובזרים ברמה מאוד גבוהה, אם זה מיטה זוגית

גדולה king size נוחה ומעוצבת, לפעמים

מיטות אפריון או מיטה עגולה, תלוי בעיצוב היחידה,

על המיטה מצעים לבנים, עליהם פזורים עלי כותרת

אדומים או נרות ריחניים סביב, הכל כדי שיהיה לכם מקום לרומנטיקה וכדי שתוכלו להגשים את האהבה שלכם.

עיסוי ארוטי עם שמנים וריחות בלתי נשכחים, מצעים חדשים ונקיים, אמבטיה מאובזרת

בשמנים וסבונים נעימים, ג’קוזי, מטבח מאובזר, מיטה וחדר שינה שצריך לראות בשביל להבין והרשימה קצרה מלהכיל.

אם באם לכם להתפנק בעיסוי ארוטי או במסג’ מפנק ואין לכם

אפשרות בדירה שלכם לקבל את הפינוקים הללו – דירות דיסקרטיות רחובות

יאפשרו לכם לקבל את כל הפינוקים הללו.

כל השירותים הללו הפכו את שירותי

הליווי לפופולרים. חברתנו, חברת ניקיון בתים תל אביב, היא ותיקה מאוד

בתחום הניקיון, מהראשונים בארץ המציעים את כל שירותי הניקיון במקום אחד.

אם אתם רוצים להזמין נערת ליווי אל דירות דיסקרטיות בבת ים, חפשו באתרי האינטרנט ותמצאו שפע של מודעות מבחורות המעניקות שירותי

מין ושירותי עיסוי. אל תיכנסו לפאניקה!

הגעתם למקום הנכון! המטפלים באתר

מקבלים מטופלים בקליניקות מקצועיות ונגישות

או מאפשרים הזדמנות משובחת לקבל עיסוי בנתניה עד הבית.

כאן בפורטל הבית שלנו מובטחים

לכם כל השירותים שעברו אימות מדויק

והכול בכדי שתוכלו להרגיש ולהיות על גג העולם

גם אם אתם רק עוברי אורח בבת ים.

גיל 18. בחורה נחמדה. בחורה נחמדה.

תמונה אמיתית תמונות אמיתיות.

הסרטון הראשון הוא של כוכבת הפורנו רישל ראיין,

פצצה אמיתית עם חזה ענק, בטן שטוחה, ותחת שדורש תשומת לב.

טאשה היא מאמי ברמה עולמית, קטנה עם גוף מושלם ופנים

סקסיות ומתוקות, אוהבת ליהנות ולעשות… במקום יש טלוויזיה עם ערוצי לווין, אפשר לראות סרטים יחדיו גם ליהנות

מפינת הקפה. אם אתם רוצים ליהנות מאירוח מפנק בלב העיר, לצד חוף הים ואתרי בילוי

שוקקים, מלווה באווירה שלווה ומרגיעה במיוחד, ספא אלכסנדר הוא

המקום המושלם עבורכם. דירות מסוימות יכולות להיות קטנות מדי ולעומת זאת אחרות יכולות

להיות מרווחות מדי עבורכם, זאת לצד כך שישנן דירות הבנויות ברמת גימור גבוהה לעומת אחרות שבנויות ברמת גימור נמוכה.

נערות ליווי באשקלון יכולות להגיע לבתים פרטיים,

דירות דיסקרטיות, חדרים לפי שעה ובתי מלון.

מגוון של דירות דיסקרטיות בצפון.

אם אתם אוהבים לחרוש את הצפון ברגל או בג’יפ, אם אתם אנשים של טיולי אופניים או גלישת צוקים, בדרך לשם, מסאז’

אירוטי בצפון מאוד מתאים. להלן 5 דרכים פשוטות מאוד שבהן תוכל לשפר את שירות הלקוחות בארגון שלך… כל מתחם ספא המוצג בתיק

תק, ממוקם בלוקיישן מדויק המייצג

את אווירת הנופש השלווה של אילת במלוא תפארתה.

כל מה שעליכם לעשות הוא לחפש באינטרנט

שירותי ליווי באזור שלכם ומיד יופיע לפניכם המבחר העצום של הנשים המדהימות שרק ממתינות לקריאתכם.

אם העיסוי התאילנדי עובד

על השרירים התפוסים, עיסוי רקמות עמוק נכנס לחלקים שמפעילים את זרימת הדם ועוזר לשחרר

שרירים שנתפסו בעקבות מתח ולחץ.

במהלך הטיפול יהיה לחץ עדין ולחץ עמוק יותר.

ובכן, זאת שאלה מצוינת ורבים שמחפשים עיסוי ארוטי

בהרצליה כלל לא מודעים ליתרונות הרבים של טכניקת

הטיפול הזו. המסאג’ עוזר לגוף להיכנס להרפיה,

לשלווה למנוחה שחסרה לנו בדרך כלל בחיי היום יום העמוסים.

כאשר אנו פונים למקום עם עיסוי במרכז בספא מפנק אנו

למעשה מחפשים זמן של מנוחה ורגיעה מחיי היום

יום העמוסים והמהירים שלנו כיום.

עיסוי זה מתאים למי שתפוס בשרירי גופו כבר זמן

רב בעקבות לחצי היום יום. את המלון כדאי לשמור לאירועים מיוחדים ולהזמין עיסוי אירוטי בתל אביב ביום הולדת,

יום נישואין וכדומה. תענוג מיני ניתן להשיג לא

רק במהלך אהבה, אלא גם בתהליך של עיסוי אירוטי.

הרעיון שלנו בסופו של דבר הוא

להתרגש, להשיג מהר בדיוק את הדבר הטוב ביותר וזה אפשרי, תלוי איך אתם עושים את זה ולאיזה

אתר אם בוחרים להיכנס.

ניתן למצוא דירות דיסקרטיות באשדוד בכל הרמות

ואלו הן דירות מפנקות מאוד המיועדות במיוחד לבילויים אינטימיים זוגיים.

מעסות מפנקות ומתפנקות בכיף בדירה דיסקרטית

חדשה בלב בת ים, כל אחת במשמרת שלה!

בגלל שהם מקדישים את כל זמנם לעבודה,

בסוף אין להם בת זוג שתבלה

איתם באירוע ואז הם נעזרים בשירותיהן של נערות על מנת להתלוות אליהם אל האירוע ולא להתפדח.

י תנועות מתיחה בעצם נגרום להגמשת והארכת

מערכת השרירים, העיסוי ימריץ ויאזן את מחזור הדם יאזן את מערכת

העצבים ישרה שלווה נפשית ומאוד מומלץ לאנשים הסובלים

מבעיות גב כתפיים צוואר ובירכיים.חלק מהעיסוי זה כולל פתיחת ערוצי אנרגיה בגוף, כלומר לחיצות לאורך ערוצי אנרגיה בגוף יקנה לטיפול מימד חשוב של איזון אנרגטי כללי חשוב בגוף ,עוד טכניקה בעיסוי זה שתורמת

רבות ומסייעת לגופינו הינה לחיצות על כלי דם ראשיים כלומר לחיצה

על כלי דם ראשי מביאה לעליית לחץ דם מקומי וזמני שבעקבות

זה ישנה האטה של קצב פעימות הלב וישנה הרפיה מוחלטת ולאחר

ששיחררנו את הלחץ המקומי מנקודה זו ישנה זרימה

חדשה בבת אחת למקום דבר היעיל מאוד

לבריאות הנקודתי של האזור מאחר והזרמנו מינרלים חמצן ודם חדש דבר הכל כך נחוץ לרקמות ותאים באזור זה.הרבה פעמים מטופלים שואלים האם הם

ירגישו כאבים למשל בעיסוי תאילנדי ולכן התשובה היא

שהעיסוי אכן מורכב מפעולות

של לחיצות ומתיחות שונות שמופעלות על איבר

בגוץ כמו הרגליים או הידיים ולכן בהתחלה מאחר

ואנו מתייחסית לפעולות שבגוף אינו רגיל אליהן ואנו מביאים אותו

למקומות שהוא אינו רגיל להגיע אז אכן תיתכן תחושת אי נעימות או חוסר

נוחות לכמה רגעים אבל תחושת הכאב הרגעית מתחלפת בשחרור מדהים ומרגיע עקב

זרימת דם חדש למקומות אלו ואנו בעצם מעירים את המקום

ומחדשים אספקת דם מינרלים וחמצן הכל כך

נחוץ לאיברים אלו שלא קיבלו מלכתחילה עוד מלפני

העיסוי חשוב לציין שלא חייבים לסבול

במקרה ואתם חשים אי נוחות או כאבים חזקים למדי יש לומר למעסה ויתכן שעיסוי זה אינו מתאים לכם בשלב זה .

נמצאו 1 קליניקות להשכרה בבאר שבע מתאימים

לפי החיפוש שלכם. חברת בטר באלאנס מפעילה מספר קליניקות בפריסה ארצית הממוקמים במרכזים רפואיים ועומדים לרשות המטופלים שישה ימים בשבוע.

שיפוץ חכם מרכז עבורכם את

כל קבלני השיפוצים בפריסה ארצית.

מרכז המומחים לביטוח ופיננסים מעניקים שירות מצוין ופוליסות משתלמות ב-30 השנים האחרונות.

לחברת ליאור צוות יועצי בטיחות, ממונה בטיחות בעבודה ומדריכי בטיחות במגוון תחומים המעניקים

שירות איכותי, מהיר, ויעיל ללא פשרות וברמה גבוהה.

המרפאה משלבת טיפולי מומחים בכל תחומים כאשר צוות רפואי בעל ניסיון רב בביצוע טיפולי שיניים עומד

לרשותכם. המרכז בעל ניסיון של 15 שנה ובעל

מכשור מתקדם לבדיקת העין ולמיפוי קרנית וכמובן

– כל סוגי עדשות המגע לקרטוקונוס.

בעל העסק בן אדם מקסים ! יש לקחת בחשבון, שלרוב נערות הליווי ישסוכן או אדם ששומר עליהן.

כל שירות ליווי חייב לרכוש רישיון פרטני לכל אדם

שקשור או עובד בלשכה או בשירות.

שם, עבודה בשירות ליווי נחשבה יוקרתי – זה לא היה קל עבור

הבנות לקבל עבודה בסוכנות.

אוטו קאר טרייד אין הינה סוכנות רכבים בחדרה המובילה בשירות ובמקצועיות.

Artificial intelligence creates content for the site, no worse than a copywriter, you can also use it to write articles. 100% uniqueness :). Click Here:👉 https://stanford.io/3FXszd0

👉 👉 $5,000 FREE EXCHANGE BONUSES BELOW 📈 👉 PlaseFuture FREE $3,000 BONUS + 0% Maker Fees 📈 + PROMOCODE FOR NEWS USERS OF THE EXCHANGE 👉 [M0345IHZFN] — 0.01 BTC 👉 site: https://buycrypto.in.net Our site is a secure platform that makes it easy to buy, sell, and store cryptocurrency like Bitcoin, Ethereum, and More. We are available in over 30 countries worldwide.

עומר כהן טכנאי מחשבים באזור בקעת אונו והמרכז מבצע תיקון שדרוג למחשבים נייחים וניידים אפשרות להגעה עד בית הלקוח .אני מציע שירות אישי הגון מקצועי ומחירים טובים !

מולטיטסקיג פי.סי מציעה מגוון

שירותי מחשוב, רשתות, אלקטורניקה ועוד בערים שונות באיזור המרכז עם אפשרות מתן

שירות עד הבית. נילי בחורה עם גוף מטריף, היא עושה ספורט

ויש לה גוף חטוב, חושנית ברמות ויודעת להעניק אהבה וקגש לפגישה הדיסקרטית.

עיסוי קלאסי בקרית שמונה/נהריה כללי הוא עיסוי גוף מלא.

עיסוי קלאסי ברמת הגולן כללי הוא עיסוי

גוף מלא. כשאתם מתעניינים לגבי עיסוי בחדרה , דעו

כי פתוחות בפניכם שתי אפשרויות עיקריות: עיסוי בחדרה המתבצע בבית הפרטי שלכם או עיסוי בחולון

המתבצע בקליניקה פרטית. איפה מוצאים נערות ליווי עם תמונות אמיתיות נערות ליווי

אילת, כשאתם צריכים לממש את הבילוי המעצים הזה כל מה שאתם

צריכים זה פורטל אחד שיודע ויכול לקחת אתכם כמה שיותר רחוק.

באמצע טיול עם הג’יפ? דירות

או חדרים להשכרה לפי שעה או לפי לילה בנהריה מעוצבים עם אלמנטים יוקרתיים

ומאובזרים היטב במזגן, טלוויזיה, מקלחת או

ג’אקוזי, מטבחון, שתיה חמה, פינת ישיבה, ערכת קפה.

רוצים פרטים על דירות דיסקרטיות בנהריה?

שנה את מיקומך כל 10-15 דקות, תוך הישענות על רגל אחת או השנייה, זה יפחית את העומס על עמוד השדרה,

אם אפשר, ללכת במקום, לזוז.

במילים אחרות, אסור לוותר על האטרקטיביות של נערות ליווי למלון בדרום וכדאי לנצל את ההזדמנות על מנת לבלות איתן.

בילוי עם נערות ליווי הוא דבר

נחמד. היינריך הרכיב את מערך

תנועות העיסוי השוודי עם התייחסות מובהקת

לאנטומיה ופיזיולוגיה של הגוף .

עיסוי שוודי הוליסטי הוא עיסוי מפנק השם דגש על חידוש האנרגיות של הגוף ויש לו יתרונות רבים.

ספא בתל אביב – קצת לצאת מהשגרה ולהתפנק עם עיסוי

מרגיע בספא מפנק. עולה חדש גדליה ואשתו אלישבע בלום, מתגוררים עם ארבעת ילדיהם ביישוב

עלי המקסים. אנו עובדים אך ורק עם החומרים המתקדמים ביותר בענף.

בשנת 2010 עבר לארצות הברית שם

התארח ועבד בשניים מהמכונים

המתקדמים והמובילים בטקסס.

החל את קריירת הקעקועים והפירסינג בשנת

2006 במרכז שם למד, התמחה והתמקצע.

אילן כנר, הממציא והיזם, שם לעצמו

מטרה ליצור סביבה אסתטית ובמחיר שווה לכל נפש.

מומחית בכירורגיה פלסטית, אסתטית ומשחזרת,

חברה באיגוד הישראלי לכירורגיה פלסטית.

חפשים חברה המתמחה בנדלן בתל

אביב, נדלן במרכז, נדלן בהרצליה, נדלן בהרצליה פיתוח?

במרכז רמת גן מחכה לך מעסה רוסיה

ישראלית מיוחדת במיוחד. אז החדשות הטובות הן שיש

פעולות פשוטות וזמינות אותן ניתן לבצע,

על מנת להירגע, להתפנק וליהנות, ואחת מאותן הפעולות,

היא ליצור קשר עם מעסה אשר מציע שירות של עיסוי מפנק.

תמיד ניתן להזמין שירות אישי ופרטי של נערות

ליווי בחולון המגיעות אליכם להיכן שתחליטו.

שירות דירות דיסקרטיות בדרום ברמה הכי גבוהה שרק תוכל לקבל עם תמונות עדכניות.

שמי אניה ואני נערת ליווי ברמה גבוהה ביותר.

נערות ליווי בחולון כי מגיע לכם לקבל פעם אחת עיסוי מקצועי שיבוצע על

ידי נערת ליווי המגיעה עם תעודות ורזומה עשיר מאחוריה.

בדרך כלל הוא צריך לבחור בין

פינוק עם אישה שיש לה משפחה משלה לבין ביקור אצל נערת עיסויים.

חדרים של מלונות הם בדרך כלל פינוק

יוצא מן הכלל. עיסוי מושלם בתל אביב יגרום

לכם להרגיש פינוק ושחרור מטורף תגיעו עוד היום

ותדעו מה… חשוב לנו שתדעו: מאגר הדירות הדיסקרטיות בתל אביב, מתעדכן מעת לעת,

ואנו מזמינים אתכם להיכנס בכל פעם

מחדש במקרים ואתם מבקשים לעצמכם בילוי אינטימי או מפגש דיסקרטי בתל אביב.

מרכז קליניקות חדש ומאובזר בעיר העתיקה בבאר שבע!

עיסוי מקצועי בבאר שבע יכול להינתן לכם מגבר או מאישה.

אם החלטתם להינות מעיסוי טנטרי מגבר לגבר, או מכל עיסוי מסוג

אחר, אתם מוזמנים לפנות לפורטל המעסים ולמצוא את המעסה המקצועי והמנוסה ביותר בתחום.

אך אם אתם מעוניינים בעיסוי מפנק בפתח תקוה לצורכי הנאה ורגיעה

או לרגל אירוע שמחה מסוים, תוכלו לקרוא במאמר זה על

שלושה סוגי עיסויים אשר מתאימים

למטרה זו ויעניקו לכם יום בילוי מפנק ואיכותי במיוחד אשר סביר להניח שתרצו לחזור עליו שוב כבר בשנה שאחרי.

בגלל שהם מקדישים את כל זמנם לעבודה,

בסוף אין להם בת זוג שתבלה איתם באירוע ואז הם נעזרים בשירותיהן של נערות על מנת להתלוות אליהם אל האירוע ולא להתפדח.

בין יתר הדברים שהם עושים או בוחרים לייצר, שירותי ליווי בצפון

בחיפה ובקריות הם חלק מזה וכך או

כך הם מפגישים לא מעט אנשים עם קשת נרחבת.

חברות קטנות, עצמאיים ויזמים, כולם בוחרים לפנות אל שירותי משרדים להשכרה.

בשנים שעברו שירותי ג’קוזי ספא יועדו לעשירים מופלגים בלבד.

עיסוי מפנק ברמת הגולן אינו נחלתם של אנשים חילוניים בלבד.

לא. מתחם העבודה מעטפת – מומחים ומטפלים בבית אחד

אינו מאפשר כניסת חיות למתחם

העבודה. כן. תוכלו למצוא חניה בתשלום בכחול-לבן

או חניה בחניונים הנמצאים בסביבה של מתחם מעטפת – מומחים ומטפלים בבית אחד.

השתמשו כבר עכשיו בשירותי האתר והזמינו

עיסוי אירוטי לטיפול במגע עדין ומלטף.

עיסוי ארוטי – ליטוף ומלטף הוא מסודר מגע של גוף נשי עדין.

מסאג׳ מקצועי בבאר שבע גוף באמצעות שמני ארומה, המאפשר לעסות שרירים ללא כאב ולעומק,

להירגע ולהירגע משמן הארומה. דפי זהב מציגים רשימה של מעסים מומלצים בנס ציונה שיעניקו לך מסאז’ מקצועי ועיסויים רפואיים.

פמלה הצעירה הכי לוהטת חזר , מסאז’ איטי מרגיע ומרענן לכל אורך

הגוף, כולל גב צוואר ובטן.

עיסוי טנטרי הנו עבודת עומק עם הגוף, הנשימה והקול במטרה לשחרר אנרגיה שתקועה בגוף וללמד אותה לנוע בנתיבים חדשים ומעצימים.

עם אתה חושבת שאתה גבר אלפה תזמין את לילי

עכשיו למלון בצפון. בסופו של דבר כל

גבר מחליט כיצד לבלות ועם מי לבלות.

האמת שיש לכם את כל הסיבות שבעולם מדוע לבלות עם נערות משירותי ליווי בלוד.

כאן אתם בוחרים עם מי לבלות, איך לבלות ומה לעשות לאורך כל זמן האיכות אותו קבעתם לעצמכם כיעד!

חוויה שרבים יזכרו מצאו לכם זמן להגיע

לעיסוי מושלם, התקשרו עכשיו לפגישה עם קלרה בירושלים.

my webpage … https://brittanyescourt.com/categors/Discreet-apartments-in-Kiryat.php

לא ניתן לקבוע מראש כמה עולה

עיסוי בראש העין, זאת מאחר וכל עיסוי בראש העין מבוסס על טכניקה

אחרת ואורכו משתנה. לא ניתן לקבוע מראש כמה עולה עיסוי בנתניה, זאת מאחר וכל

עיסוי בנתניה מבוסס על טכניקה אחרת ואורכו משתנה.

אם אתם מחפשים עיסוי מפנק במרכז

או עיסוי מפנק בראש העין ללא ספק זה

העיסוי בשבילכם. ישנם אנשים שמקבלים

עיסויים למטרות פינוק וכייף בביתם ולפעמים מגיעים לדירה דיסקרטית

בפתח-תקוה אך גם ישנם אנשים המבקשים לעבור עיסוי במרכז בעקבות כאב מסוים.

התייעצות עם אנשי מקצוע: אם יש יצא לכם להסתייע

בעבר באנשי מקצוע מתחומים מקבילים באזור, כמו

למשל רפלקסולוגים, מעסים רפואיים ומטפלים אלטרנטיביים בשיטות שונות,

תוכלו בהחלט לשאול אותם לגבי עיסוי ארוטי בראש העין ואם הם אכן מכירים

מקום כזה, סביר להניח שזה יהיה מקום מקצועי שייתן לכם שירות טוב.

מרגיע את הגוף: אם גם אתם כמו ישראלים רבים החיים

באזור, מרגישים שהמתח ושגרת היומיום עולים

על גדותיהם, עיסוי ארוטי בראש העין זה משהו שבהחלט יעזור להביא להקלה ולשחרור השרירים שנתפסו.

My site; https://onemodellondon.com/categors/Discreet-apartments-in-Acre.php

תמהר כי זה הזמן שלכם לבחור נערת ליווי

שתספק לכם את העיסוי שתמיד חלמתם עליו.נערות ליווי בגבעתיים כי מגיע לכם לקבל פעם אחת עיסוי מקצועי

שיבוצע על ידי נערת ליווי המגיעה עם תעודות ורזומה

עשיר מאחוריה. תהליך העיסוי המרכזי מתבצע עם או בלי שמנים, כאשר עיסוי ללא שמנים יתבצע בתנועות חיכוך,

הרעדה והקשה על ידי קצות האצבעות בלבד, בלחץ משתנה בהתאם לאזורים שונים בפנים ובהתאם לרגישות

העור. לא ניתן לקבוע מראש כמה עולה עיסוי בפתח-תקוה, זאת מאחר וכל עיסוי בפתח-תקוה מבוסס על טכניקה

אחרת ואורכו משתנה. כנראה שמרבית האנשים ששומעים את המילה “עיסוי מפנק”, מעלים בדעתם

אירוע מיוחד המצדיק חגיגה מפנקת במכון עיסויים בהרצליה.

בדירות דיסקרטיות בצפון ישנה בדרך כלל חנייה אחורית

אשר מאפשרת לכם להחנות את הרכב הרחק מעין הציבור; ואתם יכולים לעלות בבטחה

ובדיסקרטיות לבחורה שתמתין לכם לטיפול מפנק

ואיכותי . אם יש לחברה היקרה

שלך יום הולדת בקרוב או שסתם תרצי להפתיע אותה מכל סיבה אחרת תוכלי בשמחה לקחת אותה למכון

הספא שלנו ולפנק אותם בעיסוי מקצועי ואיכותי.

מסאז בתל אביב; התקשר עכשיו ; RELAX עיסוי מקצועי באווירה משפחתית.

my page … https://bustyvixennicole.com/region/Discreet-apartments-in-Holon.php

יואב בעל ניסיון משנת 2001, עם

מספר רב של מטופלים. ר עינת

כהן, פסיכולוגית קלינית מומחית, בעלת ניסיון רב בטיפול פסיכותרפויטי במבוגרים, משלבת בפסיכותרפיה מספר

גישות, כגון: הגישה הפסיכודינמית והגישה הקוגניטיבית-התנהגותית, וכן כלים כגון היפנוזה,

מדיטציה EMDR ו- CBT. ם, לטיפול במגוון מחלות ילדים כגון שיעול, נזלת, דלקות אוזניים, דלקת גרון, תולעים.

מחלות מבוגרים כגון יתר לחץ דם,

כולסטרול גבוה, עצירות, תולעים.

הרי בבית שלו או של ההורים שלך אין לכם פרטיות,

חדרים בחדרה יאפשרו לכם לבלות בפרטיות

כפי שאתם אוהבים. אין דברים כאלה בחיפה.

עיסויים זמינים לכם עם עיסוי בחיפה ובמקומות שונים בארץ: תוכלו לקבל עיסוי במכון

ספא, בבית הפרטי שלכם או בקליניקה פרטית.

לקראת עיסוי בירושלים ביקש מכם המעסה להשיב על

שאלון בריאות? משום שמדובר

בחוויה בריאה, יש להשתדל לא להיות במתח ואפילו לתכנן

את הכול כך שתוכלו להגיע גם לפני הזמן לעיסוי מפנק

באשדוד/אשקלון , אם מדובר בעיסוי המתבצע בקליניקה באשדוד/אשקלון של המעסה.

אנחנו מזמינים אתכם לצלול אל תוך מתחמי

הצימרים היוקרתיים, המציעים למבקרים בהם את

כל הטוב … תנו לנו לקחת אתכם אל החוויה.

ן, בדגש על התממשקות נוחה, שיפור חווית הקניה/מכירה/השכרה, ושקיפות מלאה

אל מול המשתמשים באתר. מנגד, כל עוד תקבלו עיסוי ברעננה בלבד לאורך כ-45 דקות ועד שעה, המחיר שתצטרכו

לשלם יהיה נוח הרבה יותר ויהפוך את חווית העיסוי

לנגישה גם לכם!

My webpage … https://rubyphuket.com/categors/Discreet-apartments-in-Karmiel.php

It was a useful article, thank you

промокод для 1xbet. Click Here:👉 http://www.newlcn.com/pages/news/promo_kod_1xbet_na_segodnya_pri_registracii.html

промокод при регистрации мелбет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

промокоды на мелбет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

промокод на мел бет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

промокод на мел бет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

промокоды мелбет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

melbet промокод при регистрации. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

купоны мелбет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

бонус код мелбет. Click Here:👉 http://lynks.ru/geshi/php/?melbet_promokod_pri_registracii_2020.html

Code Promo 1xBet. Click Here:👉 https://popvalais.ch/wp-includes/inc/?code-promo-1xbet-burkina-faso-78-000xof.html

Промокод 1xbet. Click Here:👉 https://www.medtronik.ru/images/pages/bonus_kod_na_1xbet_pri_registracii_6500_rubley.html

Промокод 1xbet. Click Here:👉 https://www.medtronik.ru/images/pages/bonus_kod_na_1xbet_pri_registracii_6500_rubley.html

Промокод 1xbet. Click Here:👉 http://www.newlcn.com/pages/news/promo_kod_1xbet_na_segodnya_pri_registracii.html

Awesome rating of https://1affiliate-review.com/ casino and sports betting affiliate programs, Great affiliate programs only with us, review, rating

Промокод 1xbet. Click Here:👉 http://www.newlcn.com/pages/news/promo_kod_1xbet_na_segodnya_pri_registracii.html

промокод 1хбет. Click Here:👉 http://www.newlcn.com/pages/news/promo_kod_1xbet_na_segodnya_pri_registracii.html

1xbet promo code. Click Here:👉 http://https://www.lafp.org/includes/pages/1xbet-promo-code-1xbet-bonus.html

Artificial intelligence creates content for the site, no worse than a copywriter, you can also use it to write articles. 100% uniqueness,5-day free trial of Pro Plan :). Click Here:👉 https://ceramicinspirations.co.uk/articles/promokod_191.html

Artificial intelligence creates content for the site, no worse than a copywriter, you can also use it to write articles. 100% uniqueness,5-day free trial of Pro Plan :). Click Here:👉 https://ceramicinspirations.co.uk/articles/promokod_191.html

бесплатный секс чат онлайн Click Here:👉 https://rt.beautygocams.com/

промокод для melbet Click Here:👉 https://caravela.coffee/pages/promokod_melbet_pri_registracii_na_pervuy_depozit.html

ADOBE PREMIERE PRO CRACK | FEBRUARY 2023 UPLOAD https://youtu.be/nJhhKTPbsM4

Unique casino online affiliate program. Fast payouts, work worldwide. Fast tech support, help with set up. Join right now.

CHATGPT DOWNLOAD 2023 TUTORIAL – FREE VERSION https://youtu.be/c5UdOH2kJQc

CHATGPT DOWNLOAD 2023 TUTORIAL – FREE VERSION https://youtu.be/c5UdOH2kJQc

Best ranking of https://bossaffiliate24.com/ affiliate programs for casino and sports betting, Great affiliate programs only with us, review, rating

I?m impressed, I have to say. Really not often do I encounter a weblog that?s both educative and entertaining, and let me let you know, you will have hit the nail on the head. Your concept is outstanding; the issue is something that not enough people are talking intelligently about. I am very blissful that I stumbled across this in my search for one thing regarding this.

Pretty section of content. I just stumbled upon your blog and in accession capital to say that I acquire actually enjoyed account your blog posts. Anyway I will be subscribing for your feeds or even I fulfillment you get entry to persistently rapidly.

Valuable information. Lucky me I found your website by accident, and I am shocked why this accident did not happened earlier! I bookmarked it.

I like the valuable info you provide in your articles. I?ll bookmark your weblog and check again here frequently. I am quite certain I?ll learn plenty of new stuff right here! Good luck for the next!

Ирригатор (также известен как оральный ирригатор, ирригатор полости рта или дентальная водяная нить) – это устройство, используемое для очистки полости рта. Оно представляет собой насадку с форсункой, которая использует воду или жидкость для очистки полости рта. Ирригаторы применяются для удаления зубного камня, бактерий и насадок из полости рта, а также для смягчения любых застывших остатков пищи и органических отходов. Ирригаторы применяются для профилактики и лечения различных патологий полости рта. Наиболее распространенные ирригаторы используются для удаления зубного камня, лечения десны, профилактики и лечения воспалений десен, а также для лечения пародонтита. Кроме того, ирригаторы используются для анестезии полости рта, а также для применения антибактериальных препаратов.. Click Here:👉 https://www.irrigator.ru/irrigatory-cat.html

Nice post. I study something more difficult on different blogs everyday. It can all the time be stimulating to learn content from other writers and observe a little one thing from their store. I?d favor to use some with the content material on my blog whether or not you don?t mind. Natually I?ll give you a link on your web blog. Thanks for sharing.

I was suggested this blog by my cousin. I am not sure whether this post is written by him as no one else know such detailed about my problem. You are incredible! Thanks!

Thanks for your publication on the traveling industry. I will also like to include that if you are a senior thinking about traveling, it truly is absolutely crucial that you buy travel insurance for seniors. When traveling, older persons are at high risk being in need of a health care emergency. Having the right insurance policy package for one’s age group can safeguard your health and provide peace of mind.

onexbet promo code. Click Here:👉 https://www.aamas.org/news/1xbet_free_code_registration.html

You could definitely see your expertise in the work you write. The world hopes for even more passionate writers like you who aren’t afraid to say how they believe. Always go after your heart.

Thanks for making me to obtain new ideas about desktops. I also contain the belief that certain of the best ways to help keep your mobile computer in perfect condition is by using a hard plastic-type material case, as well as shell, that suits over the top of the computer. These types of protective gear are model specific since they are made to fit perfectly on the natural housing. You can buy these directly from owner, or via third party sources if they are available for your notebook computer, however not every laptop can have a covering on the market. Yet again, thanks for your tips.

I haven?t checked in here for some time since I thought it was getting boring, but the last several posts are good quality so I guess I will add you back to my daily bloglist. You deserve it my friend 🙂

There are some fascinating cut-off dates on this article however I don?t know if I see all of them heart to heart. There may be some validity but I’ll take hold opinion until I look into it further. Good article , thanks and we wish extra! Added to FeedBurner as well

I beloved up to you’ll receive performed right here. The cartoon is attractive, your authored material stylish. nonetheless, you command get got an edginess over that you want be delivering the following. ill undoubtedly come further previously once more since precisely the same just about a lot incessantly within case you defend this hike.

I’ve really noticed that credit improvement activity should be conducted with techniques. If not, you are going to find yourself causing harm to your standing. In order to realize your aspirations in fixing your credit ranking you have to ascertain that from this moment you pay all of your monthly expenses promptly prior to their slated date. Really it is significant given that by never accomplishing so, all other actions that you will decide to try to improve your credit standing will not be effective. Thanks for giving your suggestions.

секс порно чат. Click Here:👉 https://rt.beautygocams.com/

That is the suitable blog for anybody who needs to seek out out about this topic. You realize a lot its nearly exhausting to argue with you (not that I truly would need?HaHa). You definitely put a brand new spin on a subject thats been written about for years. Great stuff, just nice!

промокод melbet при регистрации на сегодня. Click Here:👉 https://mebel-3d.ru/libraries/news/?melbet_2020_promokod_dlya_registracii_besplatno.html

I have acquired some new issues from your web page about computers. Another thing I have always presumed is that computers have become something that each home must have for many reasons. They provide convenient ways in which to organize homes, pay bills, search for information, study, focus on music and in some cases watch tv programs. An innovative strategy to complete most of these tasks is by using a notebook. These computer systems are mobile ones, small, strong and lightweight.

An interesting dialogue is value comment. I believe that you should write more on this topic, it may not be a taboo subject however usually individuals are not enough to speak on such topics. To the next. Cheers

Thanks for your posting on the vacation industry. I would also like contribute that if you are a senior taking into consideration traveling, it can be absolutely crucial to buy travel insurance for seniors. When traveling, senior citizens are at biggest risk of having a health care emergency. Buying the right insurance cover package on your age group can safeguard your health and provide peace of mind.

Another important issue is that if you are an elderly person, travel insurance pertaining to pensioners is something you should really look at. The more mature you are, the more at risk you’re for getting something undesirable happen to you while overseas. If you are never covered by some comprehensive insurance coverage, you could have a number of serious problems. Thanks for sharing your suggestions on this blog.

One more issue is that video games are generally serious naturally with the most important focus on knowing things rather than enjoyment. Although, we have an entertainment part to keep your children engaged, each and every game is normally designed to improve a specific experience or program, such as instructional math or research. Thanks for your post.

One thing I’d like to say is that often before obtaining more computer memory, take a look at the machine within which it could be installed. If the machine is actually running Windows XP, for instance, a memory threshold is 3.25GB. Applying over this would purely constitute a new waste. Make sure one’s motherboard can handle the upgrade volume, as well. Great blog post.

Many thanks for your post. I would like to comment that the tariff of car insurance will vary from one policy to another, simply because there are so many different issues which bring about the overall cost. For example, the make and model of the vehicle will have a massive bearing on the charge. A reliable older family car will have a more economical premium over a flashy expensive car.

Great ? I should definitely pronounce, impressed with your web site. I had no trouble navigating through all tabs as well as related info ended up being truly easy to do to access. I recently found what I hoped for before you know it in the least. Reasonably unusual. Is likely to appreciate it for those who add forums or anything, site theme . a tones way for your customer to communicate. Nice task..

Would you be interested in exchanging hyperlinks?

One thing I’ve noticed is the fact that there are plenty of misguided beliefs regarding the financial institutions intentions while talking about foreclosures. One fable in particular is the fact the bank desires your house. The lender wants your hard earned money, not your house. They want the bucks they gave you together with interest. Staying away from the bank will draw a foreclosed final result. Thanks for your write-up.

Thanks for discussing your ideas. I would also like to express that video games have been ever evolving. Better technology and innovations have made it simpler to create genuine and fun games. These kinds of entertainment video games were not that sensible when the actual concept was first being tried. Just like other designs of technology, video games also have had to grow as a result of many ages. This is testimony towards the fast continuing development of video games. Dr Vi PDO Thread Lift Melbourne 602A Bourke Street Melbourne Victoria Australia 3000

I additionally believe that mesothelioma cancer is a unusual form of cancers that is commonly found in individuals previously subjected to asbestos. Cancerous cellular material form while in the mesothelium, which is a protecting lining that covers the vast majority of body’s organs. These cells commonly form in the lining of the lungs, belly, or the sac that really encircles the heart. Thanks for sharing your ideas.

you might have an ideal blog right here! would you prefer to make some invite posts on my blog?

Thanks for some other informative blog. The place else could I get that type of info written in such a perfect way? I’ve a mission that I’m just now operating on, and I have been on the look out for such info.

Would you be thinking about exchanging hyperlinks?

I was suggested this blog by my cousin. I am not sure whether this post is written by him as no one else know such detailed about my trouble. You’re amazing! Thanks!

Wow, wonderful blog layout! How lengthy have you been running a blog for? you made running a blog glance easy. The total look of your website is great, as well as the content!

Thanks for your writing. I would also like to say that the health insurance brokerage service also works best for the benefit of the actual coordinators of the group insurance coverage. The health insurance broker is given an index of benefits wanted by a person or a group coordinator. Such a broker will is seek out individuals or perhaps coordinators that best fit those needs. Then he gifts his advice and if both sides agree, the actual broker formulates legal contract between the 2 parties.

I have observed that car insurance businesses know the automobiles which are prone to accidents and other risks. Additionally, these people know what type of cars are susceptible to higher risk as well as higher risk they have the higher your premium charge. Understanding the basic basics regarding car insurance will allow you to choose the right kind of insurance policy which will take care of your needs in case you happen to be involved in an accident. Many thanks sharing your ideas on your blog.

Thanks for any other magnificent article. The place else could anybody get that kind of info in such a perfect approach of writing? I have a presentation next week, and I am on the look for such information.

Code Promo 1xBet https://www.planeterenault.com/UserFiles/files/?code_promo_69.html

Code Promo 1xBet https://luxe.tv/wp-includes/jki/1xbet-new-registration-promo-code-bangladesh-bonus.html

Its like you read my mind! You seem to know so much about this, like you wrote the book in it or something. I think that you could do with a few pics to drive the message home a bit, but instead of that, this is wonderful blog. An excellent read. I’ll definitely be back.

Thanks for the suggestions shared on your blog. Another thing I would like to state is that fat loss is not exactly about going on a fad diet and trying to get rid of as much weight as you can in a couple of days. The most effective way to lose weight naturally is by acquiring it little by little and using some basic guidelines which can enable you to make the most through your attempt to shed pounds. You may learn and already be following some tips, but reinforcing understanding never damages.

Hiya, I’m really glad I’ve found this information. Nowadays bloggers publish just about gossips and web and this is really annoying. A good blog with interesting content, that’s what I need. Thanks for keeping this web-site, I will be visiting it. Do you do newsletters? Can’t find it.

I was just seeking this info for a while. After six hours of continuous Googleing, finally I got it in your website. I wonder what is the lack of Google strategy that do not rank this kind of informative web sites in top of the list. Generally the top web sites are full of garbage.

Super online game https://reactoonz-online.com/ where you can get money, buy your loved one a new phone or car, close your mortgage on your room and in just two months, hurry up register and win.

Great post made here. One thing I’d like to say is always that most professional career fields consider the Bachelor’s Degree as the entry level requirement for an online certification. Although Associate Certifications are a great way to get started, completing the Bachelors reveals many entrances to various occupations, there are numerous internet Bachelor Diploma Programs available via institutions like The University of Phoenix, Intercontinental University Online and Kaplan. Another concern is that many brick and mortar institutions offer Online versions of their college diplomas but commonly for a extensively higher cost than the companies that specialize in online diploma programs.

Code Promo 1xBet https://luxe.tv/wp-includes/jki/1xbet-new-registration-promo-code-bangladesh-bonus.html

Great weblog here! Additionally your site quite a bit up very fast! What web host are you using? Can I am getting your associate link on your host? I desire my web site loaded up as quickly as yours lol

I have been absent for a while, but now I remember why I used to love this website. Thank you, I?ll try and check back more often. How frequently you update your web site?

Thanks for your article. What I want to say is that when looking for a good on the internet electronics store, look for a website with comprehensive information on important factors such as the security statement, security details, any payment options, and other terms and policies. Always take time to browse the help and FAQ sections to get a superior idea of how a shop will work, what they can perform for you, and in what way you can make the most of the features.

Super ranking of Casino Affiliate Programs Review casino and sports betting affiliate programs, Great affiliate programs only with us, review, ranking

okmark your blog and check again here frequently. I am quite certain I?ll learn a lot of new stuff right here! Best of luck for the next!

I just couldn’t depart your site prior to suggesting that I

really enjoyed the usual info an individual provide on your visitors?

Is going to be again regularly to check up on new posts

That is really fascinating, You are a very skilled blogger. I’ve joined your rss feed and look forward to in the hunt for more of your fantastic post. Additionally, I have shared your web site in my social networks!

Thanks for your short article. I would also like to say that the health insurance broker also works best for the benefit of the actual coordinators of the group insurance. The health insurance agent is given a directory of benefits sought by somebody or a group coordinator. Exactly what a broker really does is try to find individuals and also coordinators which will best match up those needs. Then he offers his recommendations and if all parties agree, the particular broker formulates binding agreement between the two parties.

Thanks for your submission. I would like to say that the very first thing you will need to complete is check if you really need credit score improvement. To do that you have got to get your hands on a duplicate of your credit score. That should really not be difficult, considering that the government necessitates that you are allowed to have one free of charge copy of your actual credit report every year. You just have to check with the right individuals. You can either look at website for the Federal Trade Commission or even contact one of the main credit agencies directly.

I was just searching for this info for a while. After six hours of continuous Googleing, at last I got it in your web site. I wonder what is the lack of Google strategy that do not rank this kind of informative sites in top of the list. Usually the top web sites are full of garbage.* JJ’s Ducted Gas Heating Repairs and Installation * 162 Mitchell Rd, Lilydale VIC 3140 * 0412 531 821

Hello there, I found your website via Google while searching for a related topic, your web site came up, it looks great. I’ve bookmarked it in my google bookmarks.

An fascinating discussion is worth comment. I think that it’s best to write more on this subject, it won’t be a taboo subject but typically individuals are not enough to speak on such topics. To the next. Cheers

Thank you for this article. I’d personally also like to talk about the fact that it can often be hard when you’re in school and just starting out to create a long credit rating. There are many college students who are simply trying to survive and have a long or positive credit history are often a difficult element to have.

What?s Happening i am new to this, I stumbled upon this I have found It absolutely helpful and it has aided me out loads. I hope to contribute & assist other users like its helped me. Great job.

I’m really impressed with your writing skills as well as with the layout on your blog. Is this a paid theme or did you customize it yourself? Either way keep up the excellent quality writing, it?s rare to see a nice blog like this one these days..

One thing I’ve noticed is that often there are plenty of myths regarding the banking companies intentions if talking about foreclosure. One fairy tale in particular is that often the bank needs to have your house. The financial institution wants your hard earned money, not your home. They want the funds they gave you along with interest. Avoiding the bank will only draw a foreclosed realization. Thanks for your posting.

Thanks for sharing your ideas. I would also like to mention that video games have been ever evolving. Today’s technology and enhancements have made it simpler to create genuine and fun games. These kind of entertainment games were not that sensible when the actual concept was being tried. Just like other forms of technologies, video games also have had to progress as a result of many many years. This is testimony on the fast continuing development of video games.

Its like you read my mind! You seem to know a lot about this, like you wrote the book in it or something. I think that you could do with a few pics to drive the message home a bit, but other than that, this is wonderful blog. An excellent read. I’ll certainly be back.

Its like you read my mind! You appear to know a lot about this, like you wrote the book in it or something. I think that you can do with a few pics to drive the message home a bit, but other than that, this is excellent blog. A great read. I’ll certainly be back.

אך אם אתם מעוניינים בעיסוי מפנק בבית שמש

לצורכי הנאה ורגיעה או לרגל אירוע שמחה מסוים,

תוכלו לקרוא במאמר זה על שלושה סוגי עיסויים אשר מתאימים למטרה זו ויעניקו לכם יום בילוי מפנק ואיכותי במיוחד אשר סביר להניח שתרצו לחזור עליו שוב כבר בשנה שאחרי.

אך אם אתם מעוניינים בעיסוי מפנק בראשון לציון לצורכי הנאה ורגיעה או

לרגל אירוע שמחה מסוים, תוכלו לקרוא במאמר זה על שלושה סוגי עיסויים אשר

מתאימים למטרה זו ויעניקו לכם יום

בילוי מפנק ואיכותי במיוחד אשר סביר להניח שתרצו

לחזור עליו שוב כבר בשנה שאחרי. זהו אחד מהעיסויים בראשון לציון הפופולאריים ביותר

אשר לקוחות שאוהבים להתפנק מזמינים.

ספא מפנק בראשון לציון יכול לעזור לכם להירגע וישמש אתכם לצורך

שבירת השגרה השוחקת. גם אם תזמינו עיסוי מפנק לבית המלון בכפר

סבא/רעננה שבו אתם שוהים בבירה, האווירה תשתנה, האורות יתעממו ונרות ריחניים יהיו בכמה פינות החדר,

אתם תשכבו רק עם מגבת על גופכם

שתרד אט, אט, ככל שהעיסוי יעבור לחלקים השונים בגוף.

Also visit my web site :: https://nataliejacksonx.com/region/Discreet-apartments-in-Ashkelon.php

לסוכנות הליווי שלנו יש בנות לוהטות שעונות

על כל ההעדפות והפנטזיות המיניות שלך.

חלקן אף יסכימו להתלוות אליך לאירועים ומסיבות ותשתפנה פעולה כאילו

היו בנות זוגכם לכל דבר ועניין

והכל בדיסקרטיות מוחלטת.

זאת בשביל לאפשר אינטימיות מוחלטת ללקוחות.

זמן אינטימיות עם מעסה פרטית הוא הנאה חושנית בלתי נשכחת, שתרצו לחוות שוב

ושוב. כל אלו הם רעיונות יפים, אבל ביננו כולנו יודעים איך

גבר היה רוצה לחגוג את מסיבת הרווקים שלו – בילוי עם אישה חושנית

אשר תפנק אותו. הם מקבלים כאן כל שהם רוצים מאישה

– חברה טובה, ליווי, בילוי ובידור משותף, ובמיוחד עיסוי אירוטי נהדר!

אין חברה טובה יותר מאשר נערות ליווי בראשון לציון – לוהט וחושני.

אם אתה רוצה לעשות כיף סקסי, שזו אלטרנטיבה הרבה יותר טובה.

אם בחרתם לערוך מסיבה פרועה בווילה ניתן בהחלט להזמין נערות ליווי בראשון לציון

על מנת לשדרג את הבילוי של כולם.

אם אינכם רוצים להזמין אותן למסיבה עצמה, אלא רוצים להעניק לחבר שלכם בילוי אינטימי בהחלט חשוב

לבחור את המקום המתאים. דרך אגב,

כמה שיותר זה יותר טוב, בהחלט ניתן לבלות עם כמה בחורות לליווי בראשון לציון במקביל.

נערות ליווי בראשון לציון הוא

שירות ליווי לעיסוי בשבילך

על מנת לתת לראשך וגופך קצת רוגע ושלווה והנאה עד שכרון חושים.

שירותי ליווי בראשון לציון אין בהכרח משמעותם שהנערות

הן מראשון, הן יכולות להיות גם נערות מחו”ל אשר הגיעו לעבוד בישראל.

Feel free to visit my webpage – https://soiree-agency.com

האבחון הרפואי בשילוב עם התשאול נותן למטפל את המידע כיצד והיכן למקד את הטיפול.

הטיפול מתבצע כשהמטופל/ת שוכב/ת על מיטת טיפולים, במהלך הטיפול המטפל חושף בהדרגה את החלקים בגוף בהם הוא מטפל.

תושבי חולון יכולים להזמין נערות ליווי לדירות דיסקרטיות בשכונות החדשות או הותיקות של העיר, לתת עדיפות לחדרים לפי שעה כדי לשמור על גמישות וספונטניות וכמובן גם

ליהנות ממגוון רחב של בתי מלון קרובים ביפו, תל אביב ובת

ים. בשל האווירה המדוברת וכמות התיירים הפוקדים את אילת מידי שנה, באפן טבעי נוצר ביקוש

רב לדירות דיסקרטיות באילת, אליהן יוכלו

להגיע תיירים ומקומיים ליהנות משירותיהם של נערות ליווי ולחוות ריגוש

אמתי לגוף ולנפש. מובן שיש כמה וכמה אפשרויות כדי ליהנות

מנעות ליווי, אם זה במועדוני חשפנות, להזמין נערת ליווי למלון בו הנכם

מתאכסנים, אבל האופציה הפופולרית

ביותר היא להגיע לדירות דיסקרטיות באילת ושם לקבל את

כל השירות תחת קורת גג אחת.

כאן זה קורה גם לכם ומספק את התשובה המושלמת ביותר של נשים שוות במיוחד, נשים שיודעות

מה אתם צריכים בכדי לממש חופשה שווה ביותר באילת,

בין אם זה אחד המלונות או באחת דירות דיסקרטיות.

my blog; https://nikkirain.com/categors/Discreet-apartments-in-Netanya.php

Wow, superb blog layout! How long have you been blogging for? you made blogging look easy. The overall look of your website is wonderful, as well as the content!

Hello There. I found your blog using msn. This is a very well written article. I will be sure to bookmark it and come back to read more of your useful information. Thanks for the post. I?ll certainly comeback.

Nice post. I was checking continuously this weblog and I am inspired! Very helpful info specially the ultimate section 🙂 I take care of such information a lot. I used to be looking for this certain information for a very lengthy time. Thank you and best of luck.

I have learned result-oriented things through the blog post. One other thing I have recognized is that in most cases, FSBO sellers may reject an individual. Remember, they might prefer to not use your services. But if you maintain a gradual, professional partnership, offering aid and keeping contact for four to five weeks, you will usually be capable of win an interview. From there, a listing follows. Cheers

I’m extremely impressed with your writing skills as well as with the layout on your weblog. Is this a paid theme or did you customize it yourself? Either way keep up the nice quality writing, it is rare to see a great blog like this one nowadays..

Thanks for giving your ideas listed here. The other issue is that every time a problem appears with a computer system motherboard, persons should not consider the risk regarding repairing the item themselves because if it is not done correctly it can lead to permanent damage to the full laptop. It is almost always safe just to approach any dealer of that laptop for your repair of the motherboard. They’ve got technicians who definitely have an know-how in dealing with laptop computer motherboard problems and can make right diagnosis and undertake repairs.

You could certainly see your expertise in the paintings you write. The sector hopes for more passionate writers like you who aren’t afraid to say how they believe. At all times follow your heart.

ZkSync Free Airdrop Crypto: Your Guide to Free Coins in 2023, EARN MORE THAN $1000! https://www.tiktok.com/@bigggmoneys/video/7216825799645678854

Thanks for the strategies presented. One thing I also believe is that credit cards providing a 0 apr often entice consumers in zero interest, instant endorsement and easy on-line balance transfers, nevertheless beware of the real factor that will certainly void your 0 easy streets annual percentage rate and throw one out into the bad house in no time.

ZkSync Free Airdrop Crypto: Your Guide to Free Coins in 2023, EARN MORE THAN $1000! https://youtu.be/o1JvjQA-s-M

You should take part in a contest for one of the greatest websites on the web. I will highly recommend this website!

I was very pleased to uncover this great site. I need to to thank you for ones time for this fantastic read!! I definitely appreciated every bit of it and I have you bookmarked to look at new information on your blog.

Awesome ranking of https://casino-aff-programs.com/ casino and sports betting affiliate programs, Super affiliate programs only we have, review, rating

Fantastic items from you, man. I have be aware your stuff prior to and you are just extremely great.

I really like what you have got here, really like what

you’re stating and the way in which by which you assert it.

You’re making it entertaining and you continue to take care of to keep it

sensible. I cant wait to read far more from you.

That is really a great site.

Hi there, everything is going perfectly here and ofcourse every one is sharing data, that’s actually fine, keep up writing.

I blog often and I truly appreciate your content. This article has really peaked my interest.

I am going to bookmark your website and keep checking for new information about once per week.

I subscribed to your RSS feed as well.

Hello mates, pleasant post and fastidious urging commented at

this place, I am in fact enjoying by these.

CLAIM SPACE ID AIRDROP 2023 | EARN MORE THAN 1.007ETH | LAST CHANCE https://cos.tv/videos/play/43599695387857920

New Crypto Arbitrage Strategy | 20% profit in 10 minutes | Best P2P Cryptocurrency Trading Scheme +1200$ profit in 10 minutes https://cos.tv/videos/play/43784613877027840

I was excited to find this website. I want to to thank you for your time just for this wonderful read!! I definitely really liked every part of it and I have you saved to fav to look at new things in your blog.

גם אם תזמינו עיסוי מפנק בגבעתיים לבית המלון שבו אתם שוהים בבירה, האווירה תשתנה, האורות יתעממו ונרות ריחניים יהיו

בכמה פינות החדר, אתם תשכבו רק עם מגבת

על גופכם שתרד אט, אט, ככל שהעיסוי יעבור לחלקים השונים בגוף.

גם אם תזמינו עיסוי מפנק לבית המלון בגבעתיים שבו אתם שוהים

בבירה, האווירה תשתנה, האורות יתעממו ונרות ריחניים יהיו

בכמה פינות החדר, אתם תשכבו רק עם מגבת על גופכם

שתרד אט, אט, ככל שהעיסוי יעבור לחלקים

השונים בגוף. גם אם תזמינו עיסוי מפנק בחדרה לבית המלון שבו אתם שוהים בבירה,

האווירה תשתנה, האורות יתעממו ונרות ריחניים יהיו בכמה

פינות החדר, אתם תשכבו רק עם מגבת על גופכם שתרד אט,

אט, ככל שהעיסוי יעבור לחלקים השונים בגוף.

זוהי עובדה ידועה ולכן, זוגות באים לקבל טיפול של עיסוי מפנק בגבעתיים ,

או בכל אזור אחר בארץ תוכלו לבחור את המעסה על פי האזור שבו אתם גרים.

עיסוי אירוטי בתל אביב מפנק ומושקע להענקת חווית עיסוי מענגת תוכלו למצוא בפורטל סקס אדיר

בעמוד הבא, אז להנאתכם מחכים ? מסאג’ איכותי ומרגיע.

מסאג’ איכותי ומרגיע בדירה פרטית ודיסקרטית

בתל אביב, הרבה סבלנות והשקעה לכל מטופל,

בעיסוי יוקרתי ואישי מחכה לך לחוויה של פעם בחיים.

Also visit my homepage עוד מידע על אתר

באופן טבעי, עיסוי ארוטי, על אף היותם טיפולים מקצועיים שבהחלט מביאים להקלה על הגוף והנפש,

הם כאלו שאנשים לא נוטים להתייעץ לגביהם

עם חברים או בני משפחה וזה משהו שיכול להפוך את

האיתור של עיסוי ארוטי בתל אביב למעט

מורכב יותר. מהו עיסוי ברמת גן ? זוהי עובדה ידועה

ולכן, זוגות באים לקבל טיפול של

עיסוי מפנק ברמת הגולן , או בכל אזור אחר בארץ תוכלו לבחור את המעסה על

פי האזור שבו אתם גרים. למשל מומלץ לישון טוב בלילה שלפני העיסוי, להגיע נקיים לכיסוי, להגיע בזמן אם מדובר על עיסוי בקליניקה של המעסה, להתרוקן לפני העיסוי, לידע את

המעסה אם אתם סובלים מבעיה רפואית כלשהי.

עיסוי זה מתבסס על אנרגיית הצ’י (כלומר, בכל מקום שבו יש תנועה –

יש שינוי והצ’י הוא המביא לשינוי זה) ומיושם באמצעות לחצים

במקומות רגישים. מסיבות רווקים/רווקות, ימי

הולדת, אירועי חברה ולעתים אפילו חתונות – הם רק חלק מהאירועים שיכולים להזמין שירותי עיסוי פרטי על ידי מעסים מקצועיים.

חברת בלו פוליש מספקת פתרונות מקצועיים ואיכותיים בתחום הנקיון ועם דגש על שירותי

פוליש מגוונים. כל המדבירים בחברה

הינם מדבירים מקצועיים בעלי היתרים מתאימים.

בהליך של שירותי ליווי, נערת הליווי מגיעה עד לבית הלקוח, כאשר במידה ומסיבה כזאת או אחרת הלקוח לא

יכול לקבל את השירות בביתו, הוא תמיד יוכל להזמין חדר לפי שעה, צימר,

מלון או כל מקום אחר בו הוא יקבל את אותו שירות ליווי וייהנה

ממנו באופן המיטבי.

Feel free to surf to my homepage: עוד מידע על אתר

לצורך כך, תוכלו להיכנס לאתרי דירות דיסקרטיות ושם תוכלו הבחורה לבחור את המעסה

מתוך תמונה באתר. מה העלות של דירות דיסקרטיות בחדרה?

מחפשים דירות דיסקרטיות לבילוי מפנק ?

עיסוי מפנק בתל אביב. עיסוי שוודי בראש העין – העיסוי הקלאסי בראש העין

המוכר והאהוב שרוב הגברים בוחרים בו,

הן מבחינת חוסר ידיעה והכרה בעיסויים

אחרים והן מבחינת הצורך שלכם בעיסוי מפנק, לכיף בלבד.

זאת על מנת שהמסע יוכל לבצע את העיסוי המדויק והיעיל ביותר.

אפילו עדיף. המים החמימים וניחוח תכשירי הטיפוח מכניסים אתכם למצב

שלו ורגוע יותר – ובדיוק כך תרצו להתחיל את

העיסוי שלכם. טאקס פרי סופליי בע”מ עוסקת במכירת בשמים מקוריים בזול ממגוון המותגים המובילים בתחום הטיפוח מזה כ-10 שנים. מוסך דוד ובניו, הוקם על ידי דוד ומתופעל במקצועיות ובמומחיות רבה, על ידי אנשי מקצוע מומחים בתחום הטיפולים ברכב. WOPA הוא רעיון חדשני שמשנה את סביבת העבודה על ידי הצבת חברות סטארט-אפ בתחילת המסע לצד חברות בעלות ניסיון רב תחת קהילה אחת. אנו מתרגשים וגאים להציג את החברה שלנו, אלברט 2000. החברה שלנו, בעלת ניסיון רב במשך עשורים שלמים. אני בעלת תואר ראשון במנהל עסקים ובעלת תואר במשפטים, כך שהיקף הידע שלי נרחב. אני מירב מורה מוסמכת ליוגה אינטגרטיבית ויוגה תרפיה. מטפלת מוסמכת בנשימה מעגלית (ריברסינג) אני מאמינה בגוף וביכולת הטבעית שלו לרפא את עצמו.

Also visit my webpage לפרטים נוספים

תודה רבה, בית העסק קיבל את פנייתך,

אנו מקווים שהמענה יהיה מהיר.

אני כבר שותק על המתחרים שלנו עם גוון

כחלחל, אשר בכל יום הופך יותר ויותר ו “תודה” שבו השורות הנדירות של גברים מדללים עוד יותר.

אך אם אתם מעוניינים בעיסוי

מפנק בקרית אתא לצורכי הנאה ורגיעה או

לרגל אירוע שמחה מסוים, תוכלו לקרוא במאמר זה על שלושה סוגי עיסויים אשר מתאימים למטרה זו

ויעניקו לכם יום בילוי מפנק ואיכותי

במיוחד אשר סביר להניח שתרצו לחזור עליו שוב כבר בשנה שאחרי.

עיסויים בחיפה מתאימים גם כמתנת יום הולדת, מתנת

גיוס, מתנת אירוסין, מתנה לכבוד החגים

וכן הלאה. בפורטל שלנו תוכלו להתרשם משלל מעסים, עיסויים בתל אביב ומכוני עיסוי, כולל עיסויים בתל אביב המגיעים עד פתח הבית!

כאן בפורטל הבית תוכלו למצוא את מה שישלים לכם את הטיול או את המפגשים הלוהטים ביותר בטבריה.

בעת שאתם מגיעים פיסית אל מכון העיסויים, אתם תשלמו פחות בהשוואה לעיסוי שמגיע עד הבית.

סוכנות מכון ליווי בחולון VIP מספקת שירותי סקס ליווי בחולון ללא מין

ברמה עולמית. שירותי הליווי בפורטל למבוגרים של

תן בראש מדברים על נערות ליווי להזמנות

לבית / מלון בלבד וסומכים על העובדה שיש לכם מיקום בו תרצו לארח את נערת

הליווי שתגיע אליכם.

My blog; לפרטים נוספים

Why couldn’t I have the same or similar opinions as you? T^T I hope you also visit my blog and give us a good opinion. casino online

האמת היא, שאם נדלקתם על אחת קבועה… אני

שומעת כל הזמן סיפורים בתקשורת על כך שנערות ליווי הן מסכנות ולא בחרו את התחום וכו’… אני אישית ממש לא מזדהה עם הסיפורים האלו, כי אני בחרתי את התחום לא הוא

בחר בי ואני מכירה עוד לא מעט נערות

ליווי שהן בדיוק כמותי. נכון.

תל אביב המתירנית והליבראלית

מאפשרת לכם לגוון את חיי המין

שלכם גם בלי נערות ליווי בתל אביב והמרכז, אבל מה לעשות?

נערת ליווי בתל אביב היא מקצוענית, היא תותחית,

היא יודעת לעשות סקס כמו שצריך ולא צריך לחזר אחריה,

להשקיע, להזמין אותה לדייט, למסעדה, לסרט ובסוף להחזיר אותה הביתה, שלא לדבר על כל הטלפונים והסמסמים

שביום המחרת… תוכלו לפנק את האורחים באירוע שלכם בעיסוי מקצועי שיתבצע על ידי נערת הליווי שבחרתם , וכך תוכלו להפוך

את כל האורחים שלכם להרבה יותר מרוצים.

חלק מנערות הליווי שתראו באתר הן בחורות בתמונות אמיתיות ואם לא, אנחנו תמיד נשתדל שהתמונות יהיו

תואמות למציאות. לכן אם נראה שיש לנו

רק מפרסמים באתר העובדים עם נערות ליווי צעירות, אנחנו נדאג גם לאזן את הפרסום עם

סוכנויות המעניקות שירותי ליווי עם בחורות

מעט מנוסות יותר (מילפיות למביני עניין…).

כאן תוכלו למצוא נערות ליווי בתל אביב, בחיפה והצפון, באילת, בבאר שבע, בירושלים ועוד.

נערת ליווי חדשה בחיפה חמודה במיוחד

היא יודעת איך…

my website :: לאתר הבית

This is very helpful post.

No deposit bonus from https://zkasin0.site connect your wallet and enter promo code [3wedfW234] and get 0.7 eth + 100 free spins, Withdrawal without limits

No deposit bonus from https://zkasin0.site connect your wallet and enter promo code [3wedfW234] and get 0.7 eth + 100 free spins, Withdrawal without limits

I was looking for another article by chance and found your article casinosite I am writing on this topic, so I think it will help a lot. I leave my blog address below. Please visit once.

Good online game https://bookofdead-online.com/ where you can win money, buy yourself a new phone or a car, close the mortgage on your room and only one month, hurry up register and win.

“인천 경기 서울 수도권 전지역

선입금 없는 100% 후불제

호텔 . 모텔 . 오피스텔 . 자택 등으로 직접 방문해서 케어 해드립니다.” 출장안마

“선입금&예약금없는 후불제

시그니처출장마사지 시그니처출장안마 입니다.

자택 오피스텔 모텔 호텔 등 에서 이용가능하며

경기 인천 서울 전지역 30분 이내

방문 가능합니다” 출장안마

“서울 / 경기 / 인천 수도권 전지역

선입금이나 예약금 없이

직접 보시고 결제해주시는

100% 후불제 서비스 입니다.” 출장안마

“선입금이나 예약비 없이 계신 곳에서

편리하게 출장안마 & 출장마사지를

이용 하실 수 있습니다” 출장안마

출장안마, 출장마사지, 20대 한국인 매니저가 직접방문하는 출장안마

“이제 나가지말구 간편하게 계신곳에서 편하게 이용하세요 ~

서울 전지역 모텔 . 호텔 . 오피스텔 . 원룸 등에서

전화한통만 주시면 ok ~ !!

직접 방문해서 케어 해드립니다 ” 출장안마

Good ranking of https://gambling-affiliate24.com/ affiliate programs in the field of casino and sports betting, Best affiliate programs only with us, review, rating

Great ranking of https://best-casinoaffiliateprograms.com/ affiliate programs in the field of casino and sports betting, Great affiliate programs only with us, review, rating

Someone essentially assist to make severely articles I would state.

This is the very first time I frequented your web page and so far?

I surprised with the analysis you made to create this particular post amazing.

Great process!

First of all, thank you for your post. bitcoincasino Your posts are neatly organized with the information I want, so there are plenty of resources to reference. I bookmark this site and will find your posts frequently in the future. Thanks again ^^

כל אחד מהם יכול היום להשתמש בדירות הדיסקרטיות כדי להזמין שירותי ליווי בעפולה לפגישת עסקים אקסקלוסיבית.

רוצים לקבל עיסוי ארוטי איכותי מצוות נערות הממתינות בדירות

הדיסקרטיות? לכן אולי ניתן להבין

מדוע נערות הליווי באיזור צפון הארץ הן מבוקשות כל כך.

ניקוי והסרת כתמים ממערכות ישיבה מבד ומעור

וחידוש כל סוגי הריפודים. אך אם אתם מעוניינים בעיסוי מפנק בלוד לצורכי הנאה ורגיעה או לרגל אירוע

שמחה מסוים, תוכלו לקרוא במאמר זה על שלושה סוגי עיסויים אשר

מתאימים למטרה זו ויעניקו לכם יום בילוי מפנק ואיכותי במיוחד אשר סביר להניח שתרצו לחזור עליו שוב כבר בשנה שאחרי.

ישנן חבילות ספא הכוללות גם טיפולים

אלטרנטיביים כמו רפלקסולוגיה, שיאצו ויוגה וסביר להניח שתוכלו ליהנות מעוד אטרקציות במקום

במסגרת חבילות ספא כמו בריכת שחייה מקורה ומחוממת, חמאם

טורקי, סאונה יבשה וסאונה רטובה וטבילה

באמבט ג’קוזי ספא מפנק. ישנן כמה הוראות זהב,

לפני עיסוי מפנק בבית שמש ועוד סוגי עיסוי נוספים אשר מעסים רבים

מציעים ללקוחותיהם. העיסוי המקצועי

בנתניה/השרון תפס מקום רב בתחום הרפואה המשלימה וידוע כבר

לאורך דורות רבים כשיטת טיפול יעילה גם עבור ספורטאים וגם עבור אנשים אחרים.

My website – https://tkescorts.com/

ספא מפואר ומפנק מאוד בראשון לציון !

עיסוי מפנק בחולון. במקום דירה פרטי באווירה שקטה , מסאג’ מקצועי ברמה

מאוד גבוהה. מאז שנת 1975 ועד היום אורלוגין מעניקה

שרות מקצועי ויעיל. מנגד, כל עוד תקבלו

עיסוי בהרצליה בלבד לאורך כ-45 דקות

ועד שעה, המחיר שתצטרכו לשלם יהיה נוח הרבה יותר ויהפוך את חווית העיסוי לנגישה גם

לכם! תקבלו את כל התנאים כאילו אתם בצימר או